您可以通过以下链接,获取PDF版用户指南:

PDF下载华为容器存储套件

- 1: 前言

- 2: 概述

- 3: 快速开始

- 4: 兼容性和特性

- 4.1: 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

- 4.2: 闪存存储(OceanStor A600/A800)

- 4.3: DME(对接OceanStor A800集群)

- 4.4: 海量存储(OceanStor Pacific系列)

- 4.5: 海量存储(OceanDisk系列)

- 5: 安装部署

- 5.1: CSI

- 5.1.1: 安装前准备

- 5.1.1.1: 下载华为CSI软件包

- 5.1.1.2: 上传华为CSI镜像

- 5.1.1.3: 检查华为存储上的用户配置

- 5.1.1.4: 检查卷快照依赖组件

- 5.1.1.5: 检查主机多路径配置

- 5.1.1.6: 检查主机依赖软件状态

- 5.1.1.7: 检查CSI依赖的镜像

- 5.1.2: 安装

- 5.1.2.1: 使用Helm安装

- 5.1.2.1.1: Kubernetes、OpenShift、Tanzu安装华为CSI

- 5.1.2.1.2: CCE或CCE Agile平台安装华为CSI

- 5.1.2.1.3: Helm values.yaml参数说明

- 5.1.2.2: 手动安装

- 5.1.3: 卸载

- 5.1.3.1: 使用Helm卸载

- 5.1.3.1.1: Kubernetes、OpenShift、Tanzu卸载华为CSI

- 5.1.3.1.2: CCE或CCE Agile卸载华为CSI

- 5.1.3.1.3: 卸载CSI依赖组件服务

- 5.1.3.2: 手动卸载

- 5.1.4: 升级

- 5.1.4.1: 使用Helm升级

- 5.1.4.1.1: 从2.x或3.x升级至4.x版本

- 5.1.4.1.2: Kubernetes、OpenShift、Tanzu升级华为CSI

- 5.1.4.1.3: CCE或CCE Agile升级华为CSI

- 5.1.4.2: 手动升级

- 5.1.5: 回退

- 5.1.5.1: 使用Helm回退

- 5.1.5.1.1: Kubernetes、OpenShift、Tanzu回退华为CSI

- 5.1.5.1.2: CCE或CCE Agile回退华为CSI

- 5.1.5.2: 手动回退

- 6: 基础服务

- 6.1: 存储后端管理

- 6.1.1: 配置存储后端

- 6.1.1.1: 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

- 6.1.1.1.1: 文件系统

- 6.1.1.1.2: Dtree

- 6.1.1.1.3: 块业务

- 6.1.1.1.3.1: iSCSI

- 6.1.1.1.3.2: FC

- 6.1.1.1.3.3: NVMe over RoCE

- 6.1.1.1.3.4: FC-NVMe

- 6.1.1.2: 闪存存储(OceanStor A600/A800)

- 6.1.1.3: DME(对接OceanStor A800集群)

- 6.1.1.4: 海量存储(OceanStor Pacific系列)

- 6.1.1.5: 海量存储(OceanDisk系列)

- 6.1.2: 管理存储后端

- 6.2: 存储类管理

- 6.2.1: 配置存储类

- 6.2.1.1: 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

- 6.2.1.2: 闪存存储(OceanStor A600/A800)

- 6.2.1.2.1: 文件系统

- 6.2.1.3: DME(对接OceanStor A800集群)

- 6.2.1.3.1: 文件系统

- 6.2.1.4: 海量存储(FusionStorage Block/OceanStor Pacific系列)

- 6.2.1.5: 海量存储(OceanDisk系列)

- 6.2.2: 管理存储类

- 6.3: 持久卷管理

- 7: 高阶服务

- 8: 常见运维操作

- 8.1: 安装Helm 3

- 8.2: 信息收集

- 8.2.1: 如何获取CSI版本信息

- 8.2.2: 如何查看华为CSI日志

- 8.2.3: 日志收集

- 8.3: 下载容器镜像

- 8.4: 更新huawei-csi-controller或huawei-csi-node服务

- 8.5: 修改日志输出模式

- 8.6: 开启ReadWriteOncePod功能门

- 8.7: 配置非root用户访问Kubernetes集群

- 8.8: 配置IPv6

- 8.8.1: 首次安装华为CSI时配置IPv6

- 8.8.2: 华为CSI由IPv4切换至IPv6

- 8.9: 配置存储拓扑感知

- 8.10: 配置ALUA特性

- 8.10.1: 配置华为企业存储后端的ALUA参数

- 8.10.2: 配置分布式存储后端的ALUA参数

- 8.10.3: OceanStor V5系列ALUA特性配置策略样例

- 8.10.4: OceanStor Dorado ALUA特性配置策略样例

- 8.10.5: 分布式存储ALUA特性配置策略样例

- 9: 故障处理

- 9.1: 华为CSI服务相关问题

- 9.1.1: 启动huawei-csi-node失败,提示错误为:“/var/lib/iscsi is not a directory”

- 9.1.2: 启动华为CSI服务失败,提示错误:“/etc/localtime is not a file”

- 9.1.3: 启动huawei-csi服务时,服务启动异常, 状态显示InvalidImageName

- 9.2: 存储后端相关问题

- 9.2.1: 使用oceanctl工具创建后端失败,报错:context deadline exceeded

- 9.2.2: 使用oceanctl工具获取存储后端时,ONLINE字段值为false

- 9.2.3: 存储侧更新密码后账户被锁定

- 9.3: PVC相关问题

- 9.3.1: 创建PVC时, PVC的状态为Pending

- 9.3.2: 删除PVC前,PVC的状态为Pending

- 9.3.3: 通用临时卷扩容失败

- 9.3.4: PVC扩容的目标容量超过存储池容量导致扩容失败

- 9.4: Pod相关问题

- 9.4.1: 集群中worker节点宕机并恢复后,Pod完成failover,但是Pod所在源主机出现盘符残留

- 9.4.2: 创建Pod时,Pod的状态为ContainerCreating

- 9.4.3: 创建Pod时,Pod的状态长时间处于ContainerCreating状态

- 9.4.4: 创建Pod失败,日志显示执行mount命令超时

- 9.4.5: 创建Pod失败,日志显示执行mount命令失败

- 9.4.6: 创建Pod失败,Events日志显示“publishInfo doesn't exist”

- 9.4.7: 创建Pod失败或重启kubelet后,日志显示挂载点已存在

- 9.4.8: Pod挂载卷目录提示I/O error

- 9.4.9: Kubernetes平台第一次搭建时, iscsi_tcp服务没有正常启动,导致创建Pod失败

- 9.4.10: 创建Pod失败,日志显示启动器已关联至其他主机

- 9.4.11: 创建Pod失败,日志显示“Get DMDevice by alias: dm-x failed”

- 9.5: 对接Tanzu Kubernetes集群常见问题及解决方法

- 9.5.1: 未创建PSP权限导致Pod无法创建

- 9.5.2: 修改主机挂载点

- 9.5.3: 修改livenessprobe容器的默认端口

- 9.5.4: 创建临时卷失败

- 10: CLI命令说明

- 10.1: oceanctl命令说明

- 11: 附录

- 11.1: 通信矩阵

- 11.2: 配置自定义权限

- 11.3: 华为CSI资源管理

- 11.4: Kubernetes特性矩阵

1 - 前言

读者对象

本文档主要适用于以下读者对象:

- 技术支持工程师

- 运维工程师

- 具备存储和Kubernetes基础知识的工程师

符号约定

在本文中可能出现下列标志,它们所代表的含义如下。

2 - 概述

容器存储接口( Container Storage Interface ),简称 CSI,是一种行业标准协议,用于对接Kubernetes等容器平台与底层存储系统。华为CSI插件作为必备组件,实现华为企业存储和分布式存储产品与Kubernetes集群的对接,为容器工作负载提供持久化存储服务。

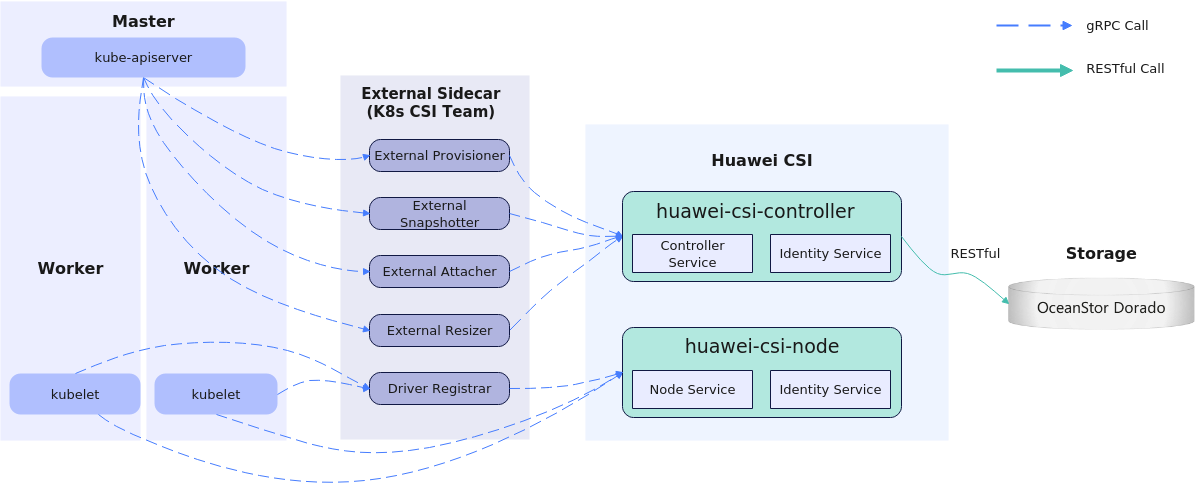

Kubernetes通过其官方维护的一系列sidecar组件负责注册监听Kubernetes对象资源,并调用CSI驱动程序,触发华为存储的物理操作。如创建一个 持久卷(Persistent Volume,PV) 时,华为CSI驱动会在存储设备中创建对应的LUN(块存储)或文件系统。Kubernetes、华为CSI以及华为存储的整体结构如 图1 所示:

华为CSI主要有两大组件,分别为huawei-csi-controller和huawei-csi-node:

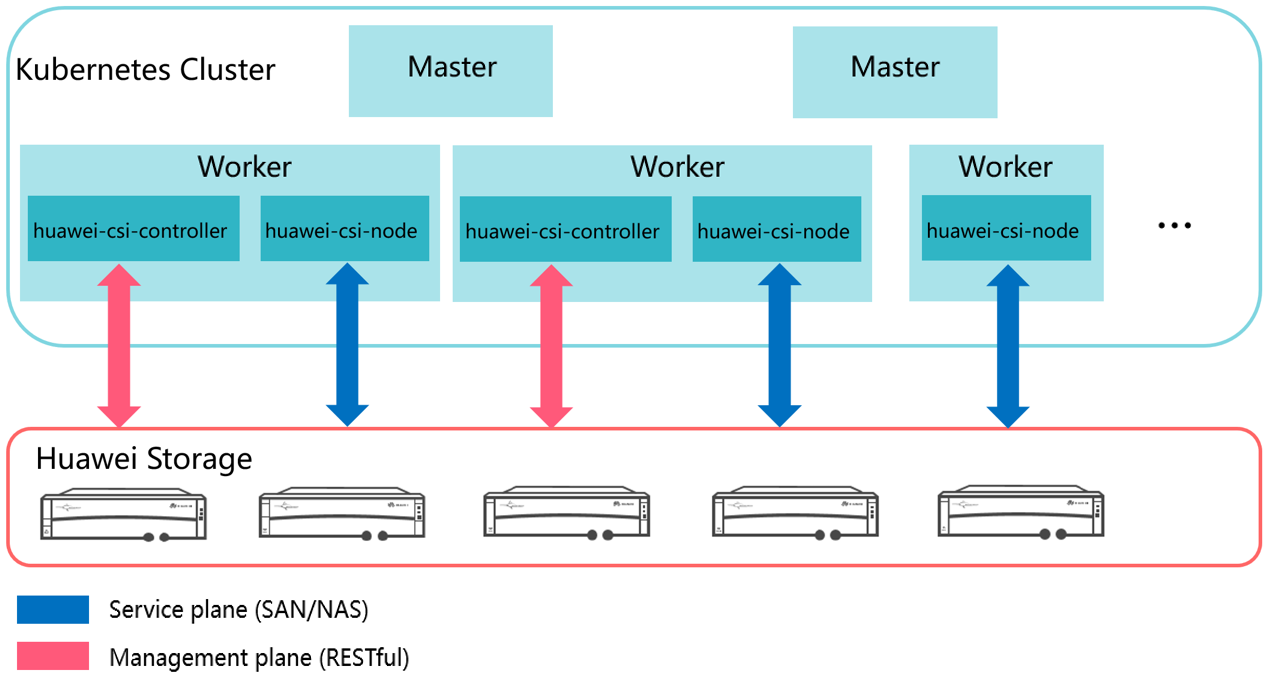

- huawei-csi-controller:包含Controller Service和Identity Service,以Deployment方式运行的一个或多个Pod,主要负责与华为存储交互,使用RESTful方式进行通信,因此运行huawei-csi-controller组件的节点需要连通存储的管理面网络。

- huawei-csi-node:包含Node Service和Identity Service,以DaemonSet方式运行在Kubernetes工作节点上的Pod,用于在工作节点上对华为存储提供的LUN/文件系统资源进行挂载和卸载等操作,因此运行huawei-csi-node组件的节点需要连通存储的业务面网络。

华为CSI的部署模型如 图2 所示:

本文档主要介绍华为CSI V4.10.0插件的安装部署和使用。

3 - 快速开始

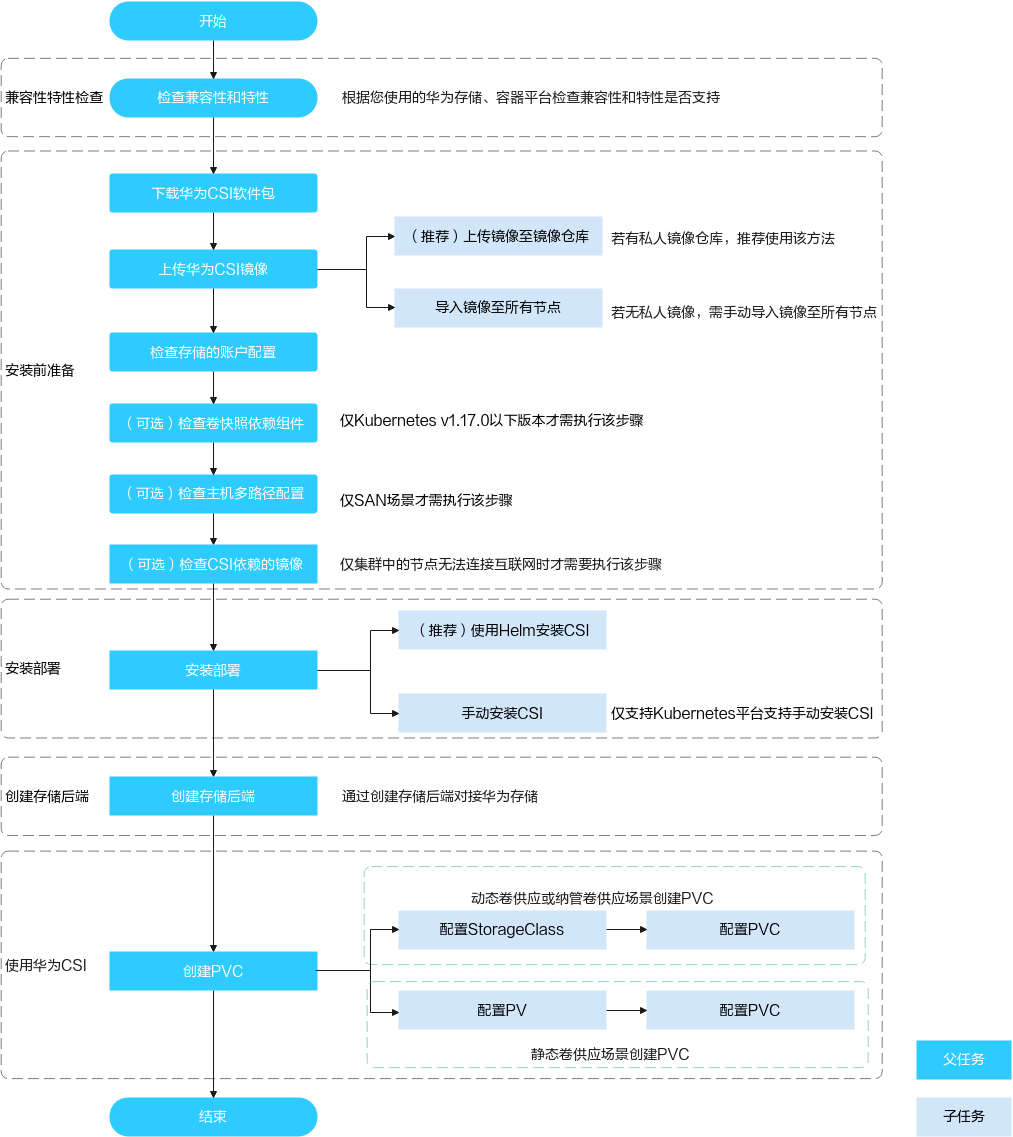

本章节说明如何快速上手安装并使用华为CSI管理PVC。

华为CSI使用流程概览

兼容性和特性

使用前请先了解对接的华为存储、容器平台和主机操作系统相关的兼容性以及支持的特性,具体请参考 兼容性和特性 。

安装前准备

安装华为CSI前,需要对容器平台、主机等环境做相关配置准备,参考 安装前准备 。

安装部署

华为CSI提供了Helm和手动安装两种安装方式,并适用于包含Kubernetes、OpenShift等不同的容器平台,参考 安装部署 。

创建存储后端

在使用华为CSI前,需要先创建存储后端资源,参考 配置存储后端 。

使用华为CSI

4 - 兼容性和特性

4.1 - 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

4.1.1 - 文件业务

4.1.1.1 - 兼容性

4.1.1.1.1 - 存储

华为CSI存储兼容性

表 1 支持的华为存储产品

6.1.0, 6.1.2, 6.1.3, 6.1.5, 6.1.6, 6.1.7, 6.1.8, V700R001C00, V700R001C10 |

表 2 华为企业存储Dtree支持的华为存储版本

6.1.0, 6.1.2, 6.1.3, 6.1.5, 6.1.6, 6.1.7, 6.1.8, V700R001C00, V700R001C10 |

4.1.1.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.1.1.1.3 - 操作系统

华为CSI操作系统兼容性

表 1 支持的主机操作系统

4.1.1.2 - 特性

4.1.1.2.1 - 华为CSI

表 1 华为存储支持的特性及约束

表 2 华为企业存储Dtree支持的特性

4.1.2 - 块业务

4.1.2.1 - 兼容性

4.1.2.1.1 - 存储

华为CSI存储兼容性

表 1 支持的华为存储产品

6.1.0, 6.1.2, 6.1.3, 6.1.5, 6.1.6, 6.1.7, 6.1.8, V700R001C00, V700R001C10 |

4.1.2.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.1.2.1.3 - 操作系统

华为CSI操作系统兼容性

表 1 支持的主机操作系统

4.1.2.2 - 特性

4.1.2.2.1 - 华为CSI

表 1 华为存储支持的特性及约束

| |||

| |||

- 若客户的容器平台部署在虚拟化平台上,CSI对接SAN存储时建议使用iSCSI协议。

- 若客户要求使用FC/NVMe over FC/NVMe over RoCE协议,需要对虚拟化平台进行特定配置,需客户侧的虚拟化团队提供技术支持。

- 使用NVMe over RoCE或NVMe over FC时,支持的nvme-cli工具版本为1.9及以上,查询命令为:nvme version。

4.2 - 闪存存储(OceanStor A600/A800)

4.2.1 - 文件业务

4.2.1.1 - 兼容性

4.2.1.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.2.1.1.3 - 操作系统

华为CSI操作系统兼容性

表 1 支持的主机操作系统

4.2.1.2 - 特性

4.3 - DME(对接OceanStor A800集群)

4.3.1 - 文件业务

4.3.1.1 - 兼容性

4.3.1.2 - 特性

4.4 - 海量存储(OceanStor Pacific系列)

4.4.1 - 文件业务

4.4.1.1 - 兼容性

4.4.1.1.1 - 存储

华为CSI存储兼容性

表 1 支持的华为存储产品

8.1.0, 8.1.1, 8.1.2, 8.1.3, 8.1.5, 8.2.0, 8.2.1, V800R001C10 |

表 2 华为分布式存储Dtree支持的华为存储版本

8.1.0, 8.1.1, 8.1.2, 8.1.3, 8.1.5, 8.2.0, 8.2.1, V800R001C10 |

4.4.1.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.4.1.1.3 - 操作系统

表 1 支持的主机操作系统

4.4.1.2 - 特性

4.4.1.2.1 - 华为CSI

表 1 华为存储支持的特性及约束

| |

表 2 华为分布式存储Dtree支持的特性

4.4.2 - 块业务

4.4.2.1 - 兼容性

4.4.2.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.4.2.1.3 - 操作系统

华为CSI操作系统兼容性

表 1 支持的主机操作系统

4.4.2.2 - 特性

4.4.2.2.1 - 华为CSI

| ||

4.5 - 海量存储(OceanDisk系列)

4.5.1 - 文件业务

4.5.1.1 - 兼容性

4.5.1.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.5.1.1.3 - 操作系统

表 1 支持的主机操作系统

4.5.1.2 - 特性

4.5.1.2.1 - 华为CSI

表 1 华为存储支持的特性及约束

4.5.2 - 块业务

4.5.2.1 - 兼容性

4.5.2.1.2 - 容器平台

华为CSI平台兼容性

表 1 支持的容器管理平台

4.5.2.1.3 - 操作系统

华为CSI操作系统兼容性

表 1 支持的主机操作系统

4.5.2.2 - 特性

4.5.2.2.1 - 华为CSI

- 若客户的容器平台部署在虚拟化平台上,CSI对接SAN存储时建议使用iSCSI协议。

- 若客户要求使用FC/NVMe over FC/NVMe over RoCE协议,需要对虚拟化平台进行特定配置,需客户侧的虚拟化团队提供技术支持。

- 使用NVMe over RoCE或NVMe over FC时,支持的nvme-cli工具版本为1.9及以上,查询命令为:nvme version。

5 - 安装部署

5.1 - CSI

5.1.1 - 安装前准备

本章节将对安装前的准备工作进行详细说明。

前提条件

- 容器管理平台已部署完成,正常运行且满足 兼容性和特性 章节中的容器平台兼容性要求。

- (企业存储必选)已完成对接华为企业存储初始化配置,包括存储池划分、端口配置等。且存储产品的版本满足 兼容性和特性 章节中的存储兼容性要求。

- (分布式存储必选)已完成对接华为分布式存储初始化配置,包括存储池划分、端口配置等。且存储产品的版本满足 兼容性和特性 章节中的存储兼容性要求。

- 完成华为存储和容器平台主机连通性配置,例如运行huawei-csi-controller的worker节点与待接入的存储设备的管理IP地址通信正常,运行huawei-csi-node的worker节点与待接入的存储设备的业务IP地址通信正常,iSCSI场景下允许使用ping命令进行连通性校验等。

- 请确保操作系统的语言是英文。

- 请确保存储池、租户名称等相关存储资源名称是英文。

5.1.1.1 - 下载华为CSI软件包

本章节详细说明了下载方法以及软件包组件结构。

打开浏览器,访问仓库地址: https://github.com/Huawei/eSDK_K8S_Plugin/releases 。

根据CPU架构,下载对应的4.10.0版本软件包。

- 软件包命名规范:插件名称(eSDK_Storage_CSI)+版本号+CPU架构。

- CSI支持的CPU架构包括:X86、ARM和PPC64LE。

将下载的软件包解压。软件包组件结构如下表所示。

表 1 软件包组件描述

5.1.1.2 - 上传华为CSI镜像

华为提供huawei-csi镜像供用户使用,镜像文件获取请参考 下载华为CSI软件包 。

为了后续在容器管理平台中可以使用CSI镜像,需要提前将CSI镜像导入到集群中:

上传镜像到镜像仓库

安装华为CSI依赖如下华为提供的镜像文件,请按照说明依次导入并上传下列镜像文件,镜像文件获取请参考 下载华为CSI软件包 。

- huawei-csi-v4.10.0-arch.tar

- storage-backend-controller-v4.10.0-arch.tar

- storage-backend-sidecar-v4.10.0-arch.tar

- huawei-csi-extender-v4.10.0-arch.tar

前提条件

已准备一台已安装Docker的Linux主机,且该主机支持访问镜像仓库。

操作步骤

执行以下命令,将CSI镜像导入当前节点。其中arch为CPU架构。

docker load -i huawei-csi-v4.10.0-<arch>.tar执行以下命令,添加镜像仓库地址到镜像标签。其中repo.huawei.com表示镜像仓库的地址。

docker tag huawei-csi:4.10.0 <repo.huawei.com>/huawei-csi:4.10.0执行以下命令,将CSI镜像上传到镜像仓库。其中repo.huawei.com表示镜像仓库的地址。

docker push <repo.huawei.com>/huawei-csi:4.10.0

- 需根据容器运行时环境(如Docker/Containerd),执行对应的CLI命令完成镜像加载与推送操作。

- CCE或CCE Agile平台请参考该平台用户手册完成镜像导入和上传。

上传镜像到本地节点

若镜像已上传至镜像仓库,则跳过本章节。

前提条件

- 该节点已获取对应的华为CSI镜像文件,镜像文件获取请参考 下载华为CSI软件包 。

- 该节点已经安装Docker或其他容器引擎。

操作步骤

- 使用远程访问工具(以PuTTY为例),通过管理IP地址,登录需要导入镜像的节点。

- 将Kubernetes CSI组件包中的"image"目录拷贝到当前节点的任意目录下。

- 执行cd image命令,进入到image的工作目录。工具路径请参见 表1 。

- 执行命令依次将image目录下的所有华为CSI镜像导入至本地节点,其中name参数是镜像tar包的名字。

使用Docker容器引擎执行:

docker load -i <name>.tar使用containerd容器引擎执行:

ctr -n k8s.io image import <name>.tar使用Podman容器引擎执行:

podman load -i <name>.tar

当节点主机安装的是其他容器引擎时,请使用对应容器引擎的导入镜像命令。

5.1.1.3 - 检查华为存储上的用户配置

当华为存储接入容器平台后,华为CSI需要在华为存储上根据业务要求管理存储资源,如创建卷、映射卷等操作。此时,华为CSI需要使用华为存储上已经创建的用户和华为存储进行通信。针对不同存储设备所需要的用户信息如下表所示。

表 1 存储对接CSI时使用的用户要求

5.1.1.4 - 检查卷快照依赖组件

本章节介绍如何检查集群中卷快照依赖组件情况。

Kubernetes v1.20之前版本部署华为CSI,请按照以下步骤检查。

执行以下命令查看Kubernetes版本。以Kubernetes版本v1.16.0为例。

kubectl get node命令结果示例如下:

NAME STATUS ROLES AGE VERSION test-master Ready master 311d v1.16.0 test-node Ready <none> 311d v1.16.0将Kubernetes CSI组件包中的"helm"目录拷贝到master节点的任意目录下。Helm工具路径请参见 表1 。

进入helm/esdk/crds/snapshot-crds目录,执行以下命令,删除快照CRD安装文件。

rm -rf ./huawei-csi-snapshot-crd-v1.yaml

5.1.1.5 - 检查主机多路径配置

当您计划在容器环境中使用FC/iSCSI/NVMe over RoCE/NVMe over FC协议对华为存储进行访问时,推荐您使用主机多路径软件增强主机和存储的链路冗余和性能。如果您不准备使用多路径软件,请跳过本章节。

华为CSI软件支持对接的操作系统和多路径软件请参考 兼容性和特性 章节中的操作系统兼容性。

- 如果您准备使用FC/iSCSI协议对接华为存储时,推荐使用操作系统自带的原生DM-Multipath。

- 如果您准备使用NVMe over RoCE/NVMe over FC协议对接华为存储时,推荐使用华为自研的UltraPath-NVMe。

- 如果您使用SCSI协议对接华为存储时,请关闭操作系统自带的DM-Multipath。

前提条件

主机多路径软件已经被正确的安装在主机上。

- 如果您使用的是操作系统自带的原生DM-Multipath,请咨询您的主机或操作系统提供商获取安装所需的资料和软件包。

- 如果您使用的是华为自研的UltraPath或者UltraPath-NVMe,请联系华为工程师获取UltraPath或者UltraPath-NVMe的资料和软件包。软件包版本请参考 兼容性和特性 章节中的操作系统兼容性。

操作步骤

如果您使用iSCSI/FC协议对接华为企业存储,请参考 OceanStor Dorado & OceanStor在Red Hat下的主机连通性指南 ,对主机多路径进行配置和检查。

如果您使用NVMe over RoCE/NVMe over FC协议对接华为企业存储,请参考 OceanStor Dorado & OceanStor在Red Hat下的主机连通性指南 ,对主机多路径进行配置和检查。

如果您使用iSCSI协议对接华为分布式存储,请参考 《FusionStorage 8.0.1 块存储基础业务配置指南》 中的“应用服务器配置多路径”章节,对主机多路径进行配置和检查。

如果您使用了操作系统原生多路径时,需要检查/etc/multipath.conf文件是否存在如下配置:

defaults { user_friendly_names yes find_multipaths no }如果配置不存在,请在/etc/multipath.conf文件开始处增加该配置项。

user_friendly_names 和find_multipaths 的参数作用请参考: dm_multipath/config_file_defaults

5.1.1.6 - 检查主机依赖软件状态

本章节介绍如何检查集群中工作节点上主机依赖软件状态是否正常。以主机操作系统为CentOS 7.9 x86_64为例。

检查iSCSI客户端状态。

systemctl status iscsi iscsid检查NFS客户端状态。

systemctl status rpcbind检查DM-Multipath多路径软件状态。

systemctl status multipathd.socket multipathd检查UltraPath多路径软件状态。

systemctl status nxup检查UltraPath-NVMe多路径软件状态。

systemctl status upudev upService_plus检查DataTurbo客户端状态,请参考 《OceanStor DataTurbo 25.1.0 DTFS用户指南》 。

检查NFS+客户端状态,请参考 《NFS+客户端 1.x 用户指南》 。

5.1.1.7 - 检查CSI依赖的镜像

华为CSI安装过程中需要依赖下表中的镜像,若集群中的所有worker节点已连接互联网且能够在线拉取镜像,则可跳过本章节。若集群中的节点无法连接互联网,则请根据使用的Kubernetes版本,下载对应的镜像文件并上传到镜像仓库中或者导入Kubernetes集群的所有worker节点中。

huawei-csi-controller服务依赖的sidecar镜像:livenessprobe、csi-provisioner、csi-attacher、csi-resizer、csi-snapshotter、snapshot-controller、storage-backend-controller、storage-backend-sidecar、huawei-csi-driver和huawei-csi-extender。huawei-csi-node服务依赖的sidecar镜像:livenessprobe、csi-node-driver-registrar和huawei-csi-driver。

关于每个镜像的功能和详情,请参考下表。

表 1 Huawei CSI依赖的镜像

集群若未连接互联网,需要手动下载容器镜像并上传到集群中,具体操作请参考 下载容器镜像 。

5.1.2 - 安装

本章节介绍如何安装华为CSI。

当前版本的华为CSI添加了资源请求和限制,具体详情请参考 华为CSI资源管理 。

前提条件

- 已完成 安装前准备 。

- 集群的所有worker节点与待接入的存储设备的业务组网通信正常,iSCSI场景下允许使用ping命令进行连通性校验。

- 集群的所有worker节点已安装对应协议所需要的软件客户端,如iSCSI客户端、NFS客户端等。

5.1.2.1 - 使用Helm安装

本章节介绍如何使用Helm 3安装部署华为CSI。

Helm安装说明

- 华为CSI的安装支持root用户和非root用户。使用非root用户安装华为CSI时,需要保证当前用户能够访问Kubernetes集群的API Server,配置非root用户访问Kubernetes集群请参考 配置非root用户访问Kubernetes集群 。

- 华为CSI必须在root用户权限下运行。

Helm是Kubernetes生态系统中的一个软件包管理工具,类似Ubuntu的APT、CentOS的YUM、或Python的pip一样,专门负责管理Kubernetes的应用资源。

使用Helm可以对Kubernetes应用进行统一打包、分发、安装、升级以及回退等操作。

- Helm的获取、安装请参考: https://helm.sh/docs/intro/install/

- Helm与Kubernetes版本对应关系请参考: https://helm.sh/docs/topics/version_skew/

Helm在安装huawei-csi-controller时,将在指定命名空间的Deployment类型的工作负载中部署以下组件:

- huawei-csi-driver:华为CSI驱动。

- storage-backend-controller:华为后端管理控制器,管理storageBackendClaim资源。

- storage-backend-sidecar:用于管理storageBackendContent资源。

- Kubernetes External Provisioner:用于提供/删除卷。

- Kubernetes External Attacher:用于挂载/解挂载卷。

- Kubernetes External Resizer:用于扩容卷。

- Kubernetes External liveness-probe: 用来判断Pod健康状态。

- (可选)huawei-csi-extender:华为CSI扩展。

- (可选)Kubernetes External Snapshotter:提供快照支持(作为CRD安装)。

- (可选)Kubernetes External Snapshot Controller :用于卷快照控制。

Helm在安装huawei-csi-node时,将在指定命名空间的DaemonSet类型的工作负载中部署以下组件:

- huawei-csi-driver:华为CSI驱动。

- Kubernetes Node Registrar:处理驱动程序注册。

- liveness-probe: 用来判断Pod健康状态。

5.1.2.1.1 - Kubernetes、OpenShift、Tanzu安装华为CSI

安装步骤

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录集群的任意master节点。

将Kubernetes CSI组件包中的"helm"目录拷贝到master节点的任意目录下。Helm工具路径请参见 表1 。

进入到helm/esdk的工作目录下。

cd helm/esdk准备values.yaml文件,华为CSI已经在软件包的helm/esdk目录下提供了values.yaml模板文件,您也可以根据 Helm values.yaml参数说明 修改参数对华为CSI进行定制。

安装前配置:

- 若容器平台为Kubernetes,可跳过该步骤。

- 若容器平台为OpenShift,请根据 OpenShift平台安装配置 进行配置。

- 若容器平台为Tanzu,请根据 Tanzu平台安装配置 进行配置。

执行命令,更新存储后端CRD

kubectl apply -f ./crds/backend/(可选) 请务必按照 检查卷快照依赖组件 章节检查快照依赖组件,确认无误后执行执行命令更新快照CRD,如果controller.snapshot.enabled参数设置为false或Kubernetes版本低于v1.20,可跳过本步骤,详情请参考 表2 。

kubectl apply -f ./crds/snapshot-crds/ --validate=false执行如下命令安装华为CSI。其中,helm-huawei-csi为自定义的Helm Chart名称,./表示使用当前目录下的Helm工程,huawei-csi为自定义的Helm Chart命名空间。

helm install helm-huawei-csi ./ -n huawei-csi --create-namespace命令结果示例如下:

NAME: helm-huawei-csi LAST DEPLOYED: Wed Jun 8 11:50:28 2022 NAMESPACE: huawei-csi STATUS: deployed REVISION: 1 TEST SUITE: None完成huawei-csi服务部署后,可执行如下命令检查服务是否启动。

kubectl get pod -n huawei-csi命令结果示例如下,Pod状态为“Running“则安装成功。

NAME READY STATUS RESTARTS AGE huawei-csi-controller-6dfcc4b79f-9vjtq 9/9 Running 0 24m huawei-csi-controller-6dfcc4b79f-csphc 9/9 Running 0 24m huawei-csi-node-g6f4k 3/3 Running 0 20m huawei-csi-node-tqs87 3/3 Running 0 20m

OpenShift平台安装配置

OpenShift平台请根据以下步骤创建SecurityContextConstraints资源。

执行命令,编辑helm_scc.yaml文件。

vi helm_scc.yaml修改helm_scc.yaml文件。其中huawei-csi是指创建的命名空间,请根据实际情况填写。

apiVersion: security.openshift.io/v1 kind: SecurityContextConstraints metadata: name: helm-scc allowHostDirVolumePlugin: true allowHostIPC: true allowHostNetwork: true allowHostPID: true allowHostPorts: true allowPrivilegeEscalation: true allowPrivilegedContainer: true defaultAddCapabilities: - SYS_ADMIN runAsUser: type: RunAsAny seLinuxContext: type: RunAsAny fsGroup: type: RunAsAny users: - system:serviceaccount:huawei-csi:huawei-csi-controller - system:serviceaccount:huawei-csi:huawei-csi-node执行命令,创建SecurityContextConstraints。

oc create -f helm_scc.yaml

Tanzu平台安装配置

Tanzu平台请执行以下命令配置kubelet安装目录。

进入到安装包的helm/esdk目录下,执行以下命令打开配置文件。安装包目录请参见 表1 。

vi values.yaml修改kubeletConfigDir参数如下并保存:

# Specify kubelet config dir path. # kubernetes and openshift is usually /var/lib/kubelet # Tanzu is usually /var/vcap/data/kubelet # CCE is usually /mnt/paas/kubernetes/kubelet kubeletConfigDir: /var/vcap/data/kubelet

Tanzu平台TKGI 1.16版本及以下请执行以下命令配置RBAC权限

执行命令, 创建rbac.yaml文件。

vi rbac.yaml粘贴如下内容至rbac.yaml,保存并退出:

apiVersion: rbac.authorization.k8s.io/v1 kind: ClusterRole metadata: name: huawei-csi-psp-role rules: - apiGroups: ['policy'] resources: ['podsecuritypolicies'] verbs: ['use'] --- apiVersion: rbac.authorization.k8s.io/v1 kind: ClusterRoleBinding metadata: name: huawei-csi-psp-role-cfg roleRef: kind: ClusterRole name: huawei-csi-psp-role apiGroup: rbac.authorization.k8s.io subjects: - kind: Group apiGroup: rbac.authorization.k8s.io name: system:serviceaccounts:huawei-csi - kind: Group apiGroup: rbac.authorization.k8s.io name: system:serviceaccounts:default执行命令,创建RBAC权限。

kubectl create -f rbac.yaml

5.1.2.1.2 - CCE或CCE Agile平台安装华为CSI

本章节介绍如何在CCE或CCE Agile平台安装华为CSI。

制作Helm安装包

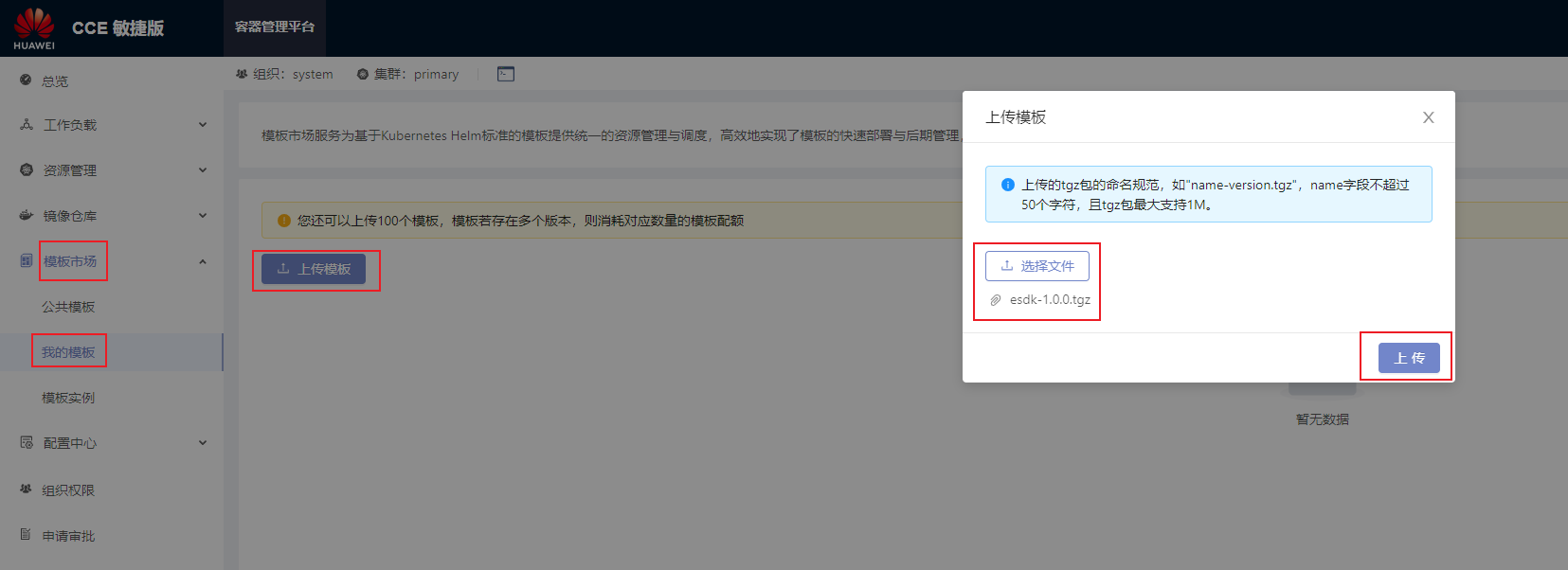

CCE或CCE Agile平台无法直接通过Helm安装华为CSI,需要手动制作Helm安装包后上传至平台模板市场进行安装。

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录已部署Helm的任意节点。

将华为CSI组件包中的"helm"目录拷贝到节点的任意目录下。Helm工具路径请参见 表1 。

进入到helm的工作目录下。

cd helm/修改helm/esdk/values.yaml文件中kubeletConfigDir和csiDriver.driverName参数。

vi ./esdk/values.yaml修改如下参数:

# Specify kubelet config dir path. # kubernetes and openshift is usually /var/lib/kubelet # Tanzu is usually /var/vcap/data/kubelet # CCE is usually /mnt/paas/kubernetes/kubelet kubeletConfigDir: /mnt/paas/kubernetes/kubelet # The CSI driver parameter configuration csiDriver: # Driver name, it is strongly recommended not to modify this parameter # The CCE platform needs to modify this parameter, e.g. csi.oceanstor.com driverName: csi.oceanstor.com执行命令制作Helm安装包,该命令会将安装包生成到当前路径下。

helm package ./esdk/ -d ./

安装华为CSI

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录已部署CCE Agile平台master的任意节点。

执行命令创建部署华为CSI的命名空间,其中huawei-csi为自定义的命名空间。

kubectl create namespace huawei-csi导出Helm安装包,具体请参考 制作Helm安装包 。

在主页单击“模板市场 > 我的模板 > 上传模板”,进入上传模板对话框。将导出的Helm安装包导入CCE Agile平台。

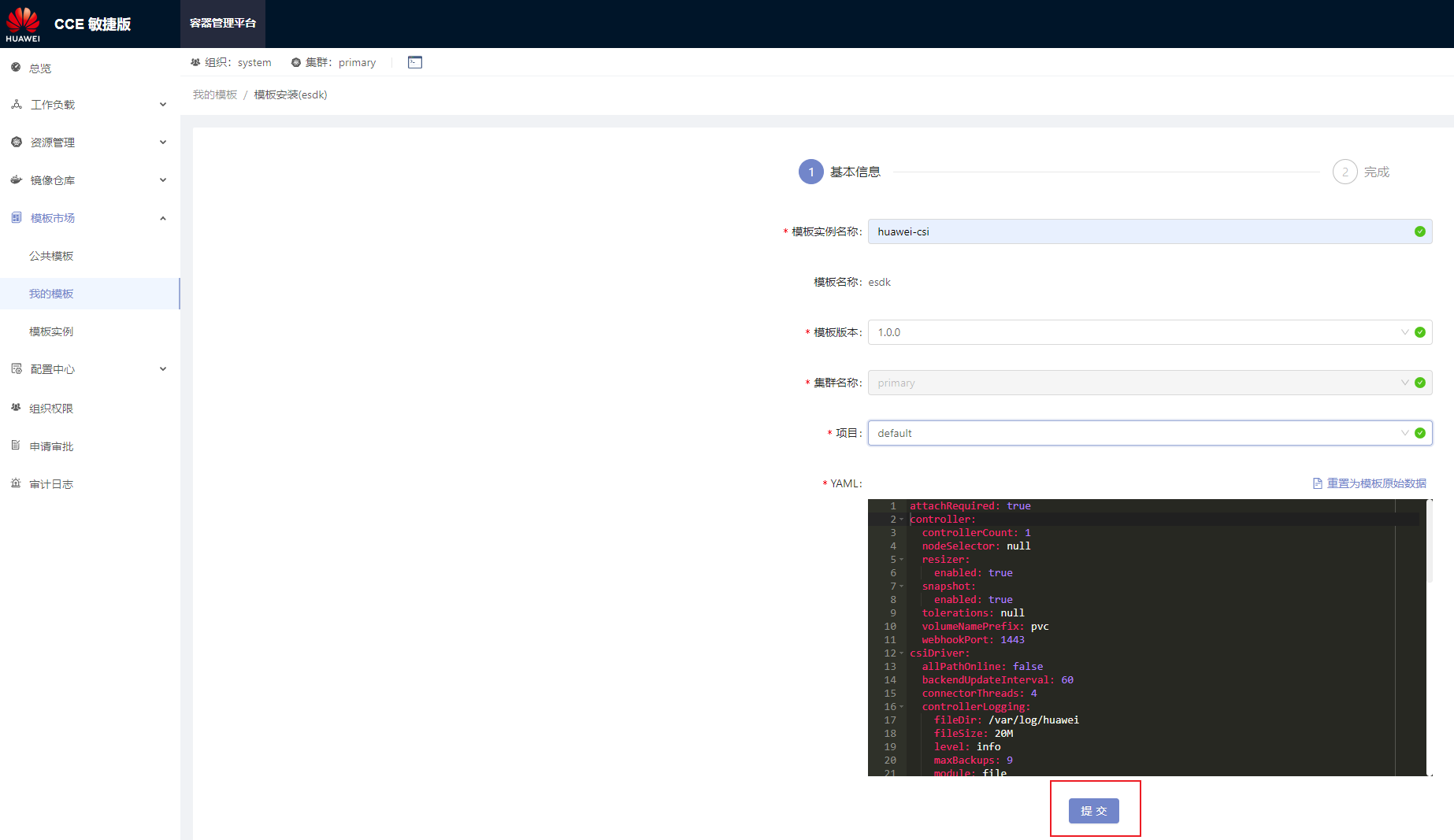

安装包上传完毕,在主页单击“模板市场 > 我的模板”,进入我的模板页面,单击“安装 > 提交”。其中模板实例名称可自定义填写。

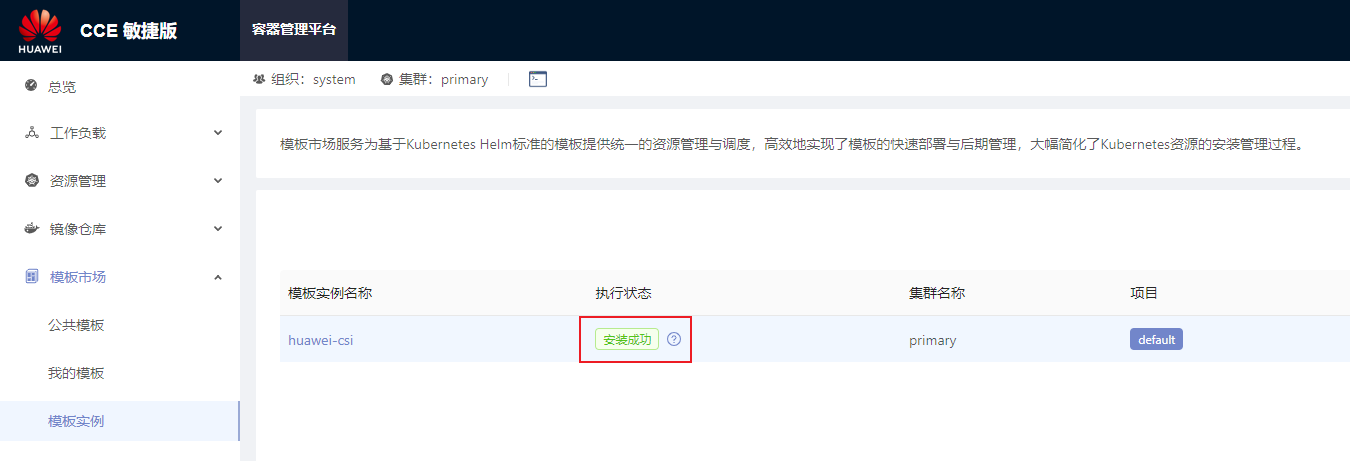

在主页单击“模板市场 > 模板实例”,选择安装时指定的项目(例如样例中的项目是“default”)。安装成功后执行状态将回显为“安装成功”。

5.1.2.1.3 - Helm values.yaml参数说明

在使用Helm安装CSI时,需要您根据部署时需要使用的特性准备Helm工程的values.yaml文件。华为CSI已经在软件包的helm/esdk目录下提供了values.yaml模板文件。

本章节将详细说明values.yaml中的配置项以及典型场景下的后端配置示例。

images参数配置说明

values.yaml中的images配置项主要配置华为CSI运行时依赖的组件镜像信息。需要配置的参数如下:

表 1 images配置项说明

livenessprobe sidecar镜像。 | |||

csi-provisioner sidecar镜像。 | |||

csi-attacher sidecar镜像。 | |||

csi-resizer sidecar镜像。 | |||

csi-snapshotter sidecar镜像。 | |||

snapshot-controller sidecar镜像。 | |||

csi-node-driver-registrar sidecar镜像。 | registry.k8s.io/sig-storage/csi-node-driver-registrar:v2.9.0 |

- huaweiCSIService、storageBackendSidecar、storageBackendController、huaweiCSIExtender参数的值,请参考 上传华为CSI镜像 章节的说明,使用最终生成镜像的名称和版本。

- 其他sidecar镜像参数,请参考 检查CSI依赖的镜像 章节的说明,使用最终上传的镜像的名称和版本。

controller参数配置说明

controller配置项用于配置huawei-csi-controller组件的相关配置。

表 2 controller配置项说明

Kubernetes版本低于v1.17时,由于Kubernetes社区提供的csi-provisioner sidecar镜像不支持--leader-election参数,只能通过单副本方式部署huawei-csi-controller组件。 | ||||

PV名称的前缀,默认值为pvc,即创建的PV名称为:pvc-<uuid>。前缀必须满足DNS 子域名的命名规则,且PV名称总长度不得超过253个字符。 | 对应的provisioner参数名称为:--volume-name-prefix。 详细配置请参考配置PV名称前缀。

| |||

huawei-csi-controller的节点选择器。配置后huawei-csi-controller仅会调度到存在该标签的节点上。 | 节点选择器的详细说明请参考:将 Pod 分配给节点 | |||

huawei-csi-controller的污点容忍。配置后huawei-csi-controller能够容忍节点上存在该污点。 | 污点和容忍度的详细说明请参考:污点和容忍度 | |||

huawei-csi-controller的节点亲和性。配置后huawei-csi-controller会优先调度到存在该标签的节点上。 | 节点亲和性的详细说明请参考:将Pod指派给节点 | |||

当controller.snapshot.enabled参数配置为true时,需要安装“helm/crd/snapshot-crds”目录下的卷快照CRD资源。

node参数配置说明

node配置项用于配置huawei-csi-node组件的相关配置。

表 3 node配置项说明

详细说明请参考:Volume Limits | ||||

节点选择器的详细说明请参考:将 Pod 分配给节点 | ||||

- key: "node.kubernetes.io/memory-pressure" operator: "Exists" effect: "NoExecute" - key: "node.kubernetes.io/disk-pressure" operator: "Exists" effect: "NoExecute" - key: "node.kubernetes.io/network-unavailable" operator: "Exists" effect: "NoExecute" | 污点和容忍度的详细说明请参考:污点和容忍度 | |||

节点亲和性的详细说明请参考:将Pod指派给节点 | ||||

当一个块设备被成功挂载之后,挂载路径的目录结构应该如下所示: /var/lib/kubelet/plugins/kubernetes.io/csi/{kubeletVolumeDevicesDirName}/publish/{specName}/{podUID} |

csiDriver参数配置说明

csiDriver配置项包括了华为CSI运行时的基本配置,如华为驱动名称、多路径类型等配置信息。

表 4 csiDriver配置项说明

如果您的容器环境已经部署了华为CSI,请确保csiDriver.driverName的设置和之前部署时的配置保持一致。否则会导致系统中已存在的有华为CSI发放的卷/快照无法被新部署的华为CSI管理。

其他参数配置说明

其他配置项包括了CSI插件某些特性的开关或者镜像获取策略。

表 5 其他配置项说明

华为CSI运行时所在Kubernetes命名空间,支持用户自定义。名称必须由小写字母、数字和“-”组成,例如:my-name、123-abc。 | ||||

| ||||

详细说明请参考:从私有仓库拉取镜像 | ||||

CSIDriver特性在Kubernetes v1.18成为GA版本,因此要求Kubernetes版本高于v1.18,当Kubernetes版本低于 v1.18时,请设置该参数为false。 | ||||

| 参数attachRequired在Kubernetes v1.18支持配置。 如果CSIDriverObject.isCreate为true并且attachRequired参数设置为false时,huawei-csi插件将不会部署csi-attacher这个sidecar。

| |||

基础卷是否支持在装载之前更改卷的所有权和权限。支持配置如下参数:

| 参数fsGroupPolicy在Kubernetes v1.20支持配置,并且当CSIDriverObject.isCreate为true时该参数生效。 该特性在Kubernetes v1.20中为Beta版本,在Kubernetes v1.23成为GA版本,因此要求Kubernetes版本高于v1.20。 | |||

| ||||

| ||||

可以对huawei-csi-controller和huawei-csi-node相关容器资源进行分配: resources.<component>.<container-name>

controller.<container-name>支持的参数:

| 各容器资源分配默认值,请参考:华为CSI资源管理 | 以huawei-csi-controller的livenessProbe为例: resources: controller: limits: cpu: 100m memory: 128Mi requests: cpu: 10m memory: 128Mi |

请确保此kubernetes.namespace填入的命名空间在Kubernetes上已经存在,如果不存在请使用如下命令创建对应的命名空间。本例中,华为CSI运行的命名空间为“huawei-csi”。kubectl create namespace huawei-csi

5.1.2.2 - 手动安装

本章节介绍如何手动安装华为CSI。

手动安装华为CSI当前仅支持Kubernetes平台。

安装步骤

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录集群的任意master节点。

将Kubernetes CSI组件包中的"manual"目录拷贝到master节点的任意目录下。

执行命令创建一个命名空间,此处空间名称以huawei-csi为例。

kubectl create ns huawei-csi进入到manual/esdk的工作目录下。具体路径请参见 表1 。

cd manual/esdk执行命令,更新存储后端CRD

kubectl apply -f ./crds/backend/(可选) 请务必按照 检查卷快照依赖组件 章节检查快照依赖组件,确认无误后执行执行命令更新快照CRD,如果Kubernetes版本低于v1.20,跳过本步骤。

kubectl apply -f ./crds/snapshot-crds/ --validate=false(可选) 执行命令安装CSIDriver。如果不使用CSIDriver特性,可跳过本步骤,详情请参考 CSIDriver 特性。

kubectl apply -f ./deploy/csidriver.yaml执行命令安装huawei-csi-controller服务。

如果Kubernetes版本低于v1.20,需要对 ./deploy/huawei-csi-controller.yaml 文件进行如下修改:- Kubernetes版本低于v1.20时,不支持快照特性,删除名称为csi-snapshotter和snapshot-controller这两个与快照相关的容器配置。 如果Kubernetes版本低于v1.17,需要对 ./deploy/huawei-csi-controller.yaml 文件进行如下修改:

- Kubernetes版本低于v1.17时,不支持快照特性,删除名称为csi-snapshotter和snapshot-controller这两个与快照相关的容器配置。

- Kubernetes版本低于v1.17时,由于Kubernetes社区提供的csi-provisioner sidecar镜像不支持–leader-election参数,删除csi-provisioner容器leader-election参数配置,且仅支持单副本部署。

- 根据 检查CSI依赖的镜像 中的版本要求,修改依赖的镜像版本。

kubectl apply -f ./deploy/huawei-csi-controller.yaml执行命令安装huawei-csi-node服务。

kubectl apply -f ./deploy/huawei-csi-node.yaml执行命令检查服务是否启动。

kubectl get pod -n huawei-csi回显示例如下,Pod状态为“Running“则安装成功。

NAME READY STATUS RESTARTS AGE huawei-csi-controller-68745d489c-v5xkj 9/9 Running 0 13m huawei-csi-node-4hbqp 3/3 Running 0 13m huawei-csi-node-f7dkf 3/3 Running 0 13m huawei-csi-node-xrntc 3/3 Running 0 13m

多副本controller部署场景下可以通过修改 ./deploy/huawei-csi-controller.yaml 文件中Deployment资源的spec.replica字段来指定副本个数,修改完成后,执行kubectl apply -f ./deploy/huawei-csi-controller.yaml使配置生效。

5.1.3 - 卸载

本章节介绍如何卸载华为CSI。根据您安装时的方式,请使用不同的方式进行卸载。

如果您不是出于升级的目的卸载华为CSI,请确保卸载华为CSI前已经在您的容器平台中将华为CSI发放的资源(PV、PVC、快照、存储后端等)全部清理。否则一旦您卸载华为CSI后,这些资源将无法被自动调度、管理或者清理。

5.1.3.1 - 使用Helm卸载

5.1.3.1.1 - Kubernetes、OpenShift、Tanzu卸载华为CSI

本章节介绍如何在Kubernetes、OpenShift、Tanzu平台卸载华为CSI。

操作步骤

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令卸载华为CSI,其中 helm-huawei-csi 是自定义的Helm Chart名称,huawei-csi 是该Helm Chart所在的命名空间。该卸载命令将会卸载华为CSI的huawei-csi-controller、huawei-csi-node和RBAC资源。

helm uninstall helm-huawei-csi -n huawei-csi卸载命令执行后,还需要检查卸载是否成功。其中 huawei-csi 为chart所在的命名空间。

helm list -n huawei-csi命令结果示例如下,如果回显为空,则表示服务卸载成功。

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION卸载huawei-csi-host-info对象,请参考 卸载huawei-csi-host-info对象 进行操作。

卸载webhook资源,请参考 卸载Webhook资源 进行操作。

(可选)卸载快照依赖组件服务,请参考 卸载Snapshot依赖组件服务 进行操作。

(可选)卸载Lease资源,请参考 卸载Lease资源 进行操作。

(可选)执行以下命令,删除华为CSI所在的命名空间,这里以默认命名空间 huawei-csi 为例:

kubectl delete ns huawei-csi

5.1.3.1.2 - CCE或CCE Agile卸载华为CSI

本章节介绍如何在CCE或CCE Agile平台卸载华为CSI,以CCE Agile v22.3.2为例。

操作步骤

登录CCE Agile平台。

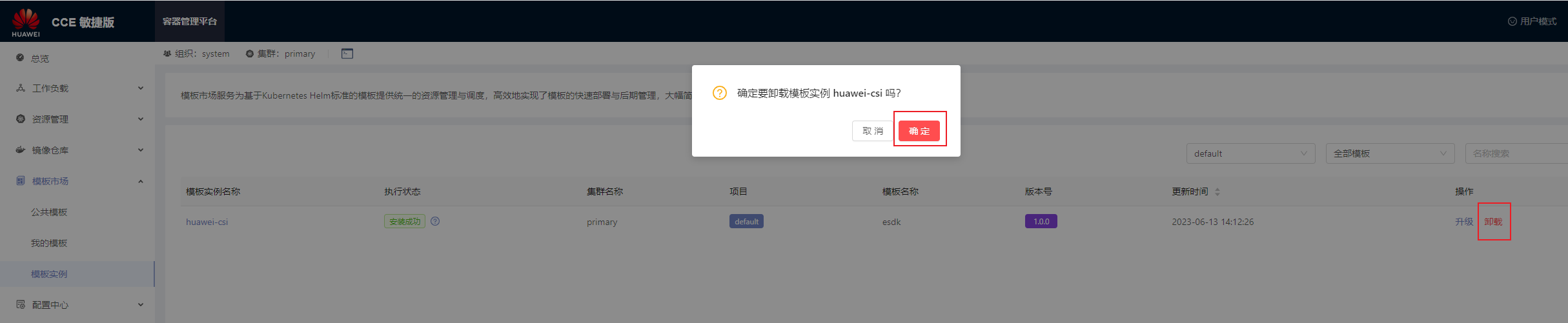

在主页单击“模板市场 > 模板实例 ”,进入模板实例页面。

选择华为CSI模板实例,单击“卸载”,在弹出的提示框中单击“确定”。

卸载huawei-csi-host-info对象,请参考 卸载huawei-csi-host-info对象 进行操作。

卸载webhook资源,请参考 卸载Webhook资源 进行操作。

(可选)卸载快照依赖组件服务,请参考 卸载Snapshot依赖组件服务 进行操作。

(可选)执行以下命令,删除华为CSI所在的命名空间,这里命名空间以 huawei-csi 为例:

kubectl delete ns huawei-csi

5.1.3.1.3 - 卸载CSI依赖组件服务

本章节介绍如何卸载CSI依赖组件服务。

卸载huawei-csi-host-info对象

名称为huawei-csi-host-info的Secret对象中保存着集群中各个节点的启动器信息,例如iSCSI启动器。使用helm uninstall命令时不会卸载该资源,若需卸载该资源,请参考以下步骤:

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令卸载Secret对象,其中huawei-csi-host-info是Secret对象的名称,huawei-csi是Secret对象所在的命名空间。

kubectl delete secret huawei-csi-host-info -n huawei-csi执行以下命令检查Secret对象是否卸载成功。

kubectl get secret huawei-csi-host-info -n huawei-csi命令结果示例如下,如果命令回显提示“NotFound”表示huawei-csi-host-info对象已成功卸载。

Error from server (NotFound): secrets "huawei-csi-host-info" not found

卸载Webhook资源

名称为storage-backend-controller.xuanwu.huawei.io的webhook资源用于校验Backend的秘钥信息和与存储的连通性,使用helm uninstall命令时不会卸载该资源,若需卸载该资源,请参考以下步骤:

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令,查询webhook依赖组件服务。

kubectl get validatingwebhookconfigurations.admissionregistration.k8s.io storage-backend-controller.xuanwu.huawei.io命令结果示例如下:

NAME WEBHOOKS AGE storage-backend-controller.xuanwu.huawei.io 1 12d执行以下命令,卸载webhook依赖组件服务。

kubectl delete validatingwebhookconfigurations.admissionregistration.k8s.io storage-backend-controller.xuanwu.huawei.io执行以下命令,检查服务是否已成功卸载。如果结果为空,表示已成功卸载。

kubectl get validatingwebhookconfigurations.admissionregistration.k8s.io storage-backend-controller.xuanwu.huawei.io

卸载Snapshot依赖组件服务

- 请勿在存在快照时卸载Snapshot依赖组件服务,否则Kubernetes会自动删除所有的用户快照且无法恢复。详细说明请参见 删除 CustomResourceDefinition 。

- 请勿在CSI升级时卸载Snapshot依赖组件服务。

场景说明

- 当前华为CSI使用了快照特性。

- 当前Kubernetes集群仅存在华为CSI,且不再使用华为CSI。

- 在卸载前请确保在Kubernetes集群中已经没有华为CSI管理的VolumeSnapshot资源。

操作步骤

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令,卸载Snapshot依赖组件服务。

kubectl delete crd volumesnapshotclasses.snapshot.storage.k8s.io volumesnapshotcontents.snapshot.storage.k8s.io volumesnapshots.snapshot.storage.k8s.io执行以下命令,检查服务是否已成功卸载。如果结果为空,表示已成功卸载。

kubectl get crd | grep snapshot.storage.k8s.io

卸载Lease资源

当使用多副本方式部署huawei-csi-controller时,会生成Lease资源,用于保存当前Holder信息。使用helm uninstall命令时不会卸载该资源,若需卸载该资源,请参考以下步骤:

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令,查询Lease信息。

kubectl get lease -n huawei-csi命令结果示例如下:

NAME HOLDER AGE csi-huawei-com node-1 24d external-attacher-leader-csi-huawei-com node-1 24d external-resizer-csi-huawei-com node-1 24d external-snapshotter-leader-csi-huawei-com node-1 24d snapshot-controller-leader node-1 24d storage-backend-controller node-1 24d huawei-csi-extender node-1 24d执行以下命令,卸载Lease资源。

kubectl delete lease -n huawei-csi csi-huawei-com external-attacher-leader-csi-huawei-com external-resizer-csi-huawei-com external-snapshotter-leader-csi-执行以下命令,检查是否已成功卸载。

kubectl get lease -n huawei-csi命令结果示例如下,如果结果为空,表示已成功卸载。

No resources found in huawei-csi namespace.

5.1.3.2 - 手动卸载

本章节介绍如何手动卸载华为CSI。

如果您不是出于升级的目的卸载华为CSI,请确保卸载华为CSI前已经在您的容器平台中将华为CSI发放的资源(PV、PVC、快照、存储后端等)全部清理。否则一旦您卸载华为CSI后,这些资源将无法被自动调度、管理或者清理。

卸载huawei-csi-node服务

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令卸载 huawei-csi-node 服务,huawei-csi 替换为华为CSI所在的命名空间。

kubectl delete daemonset huawei-csi-node -n huawei-csi执行以下命令检查服务是否已成功卸载(如果提示NotFound错误,表示已成功卸载)。

kubectl get daemonset huawei-csi-node -n huawei-csi

卸载huawei-csi-controller服务

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令卸载 huawei-csi-controller 服务,huawei-csi 替换为华为CSI所在的命名空间。

kubectl delete deployment huawei-csi-controller -n huawei-csi执行以下命令检查服务是否已成功卸载(如果提示NotFound错误,表示已成功卸载)。

kubectl get deployment huawei-csi-controller -n huawei-csi

卸载csidriver对象

如果 安装时未使用CSIDriver特性 ,可跳过本步骤。

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令卸载csidriver对象。

kubectl delete csidriver csi.huawei.com执行以下命令检查服务是否已成功卸载(如果提示NotFound错误,表示已成功卸载)。

kubectl get csidriver csi.huawei.com

删除RBAC权限

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

删除RBAC权限。

kubectl -n huawei-csi -l provisioner=csi.huawei.com delete ServiceAccount,Service,role,rolebinding,ClusterRole,ClusterRoleBinding

其它资源卸载

卸载huawei-csi-host-info对象,请参考 卸载huawei-csi-host-info对象 进行操作。

卸载webhook资源,请参考 卸载Webhook资源 进行操作。

(可选)卸载快照依赖组件服务,请参考 卸载Snapshot依赖组件服务 进行操作。

(可选)卸载Lease资源,请参考 卸载Lease资源 进行操作。

(可选)执行以下命令,删除华为CSI所在的命名空间,这里以默认命名空间 huawei-csi 为例:

kubectl delete ns huawei-csi

5.1.4.1 - 使用Helm升级

本章节介绍如何升级华为CSI。

- 如果您从2.x版本升级至4.10.0版本,请参考旧版本用户指南卸载CSI,然后参考 使用Helm安装 章节安装华为CSI。

- 如果您从2.x或3.x版本升级至4.10.0版本,请参考 从2.x或3.x升级至4.x版本 章节升级华为CSI。

- 如果您从4.x版本升级至4.10.0版本,请参考 Kubernetes、OpenShift、Tanzu升级华为CSI 章节升级华为CSI。

- 部分2.x版本CSI已经下架,若升级失败,可能无法回退到已下架版本的CSI。

- 从2.x或3.x版本或4.x版本升级至4.10.0版本,可能存在旧版本已发放Pod重新挂载时失败的问题,具体请参考 从2.x或3.x升级至4.x版本

- 在升级/回退过程中,不能使用华为CSI创建新的资源,或者对已有的PVC做挂载/卸载操作。

- 在升级/回退过程中,请勿卸载Snapshot依赖组件服务。

- 升级/回退过程中,已经存在的PVC/快照/Pod等资源会正常运行,不会影响您的业务访问。

5.1.4.1.1 - 从2.x或3.x升级至4.x版本

在CSI 2.x或3.x 版本中,使用块存储时,与存储建立映射的操作是在huawei-csi-node服务进行的,所以huawei-csi-node服务需要和存储管理网络通信。又由于huawei-csi-node服务是以DaemonSet部署的,在集群中每个节点都会部署一个huawei-csi-node服务,这样部署模型导致了在大规模集群下,每个huawei-csi-node服务都会向存储发起请求,可能导致存储连接数被占满,使得huawei-csi-node不能提供正常服务。 在CSI 4.x版本优化了该部署模型,将与存储建立映射操作迁移至huawei-csi-controller服务,huawei-csi-node服务不再需要和存储管理网络通信,降低了华为CSI依赖的组网复杂度,同时huawei-csi-controller服务以Deployment形式部署,副本数根据客户可靠性要求设置,一般情况下,副本数为1~3。所以极大的减少了华为CSI与存储的连接数量,使得华为CSI服务能够接入大规模集群。 该架构变化可能会导致一个问题:升级后,使用2.x或3.x发放的工作负载,升级CSI至4.x版本之后,如果产生了一次新的挂载流程,并且CO(Container Orchestration system)未调用华为CSI提供的huawei-csi-controller服务,会导致挂载失败。问题请参考 创建Pod失败,Events日志显示“publishInfo doesn’t exist” 。

从2.x或3.x将华为CSI升级至4.x版本,请参考以下步骤进行操作。

备份存储后端配置

如果您已按照以上须知评估风险后,确认需要从2.x或3.x版本的CSI升级至4.10.0版本,请按照以下操作步骤备份存储后端配置:

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行以下命令备份后端信息到configmap.json文件中。OpenShift平台使用oc替换kubectl命令。

kubectl get cm huawei-csi-configmap -n huawei-csi -o json > configmap.json

升级华为CSI

请按照 升级华为CSI 中的步骤进行升级。

配置存储后端

请将 备份存储后端配置 中备份的后端信息,按照 存储后端管理 章节的说明配置存储后端,存储后端配置成功后,请务必按照以上须知所述的风险处理方法进行操作,避免Pod在漂移过程中出现问题。

5.1.4.1.2 - Kubernetes、OpenShift、Tanzu升级华为CSI

前提条件

- 旧版本华为CSI使用Helm安装。

- 新版本华为CSI镜像已制作完成,并且按照 上传华为CSI镜像 章节说明,上传到镜像仓库或者导入到所有节点。

升级华为CSI

如果您旧版本CSI使用Helm部署,请按照以下操作步骤升级华为CSI。

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

将目标版本CSI组件包拷贝到master节点的任意目录下。

进入到helm/esdk的工作目录下,目录路径请参见 表1 。

cd helm/esdk执行kubectl apply -f ./crds/backend/命令,更新存储后端CRD

kubectl apply -f ./crds/backend/(可选) 请务必按照 检查卷快照依赖组件 章节检查快照依赖组件,确认无误后执行执行以下命令更新快照CRD,如果controller.snapshot.enabled参数设置为false或Kubernetes版本低于v1.20,可跳过本步骤,详情请参考 表2 。

kubectl apply -f ./crds/snapshot-crds/ --validate=false执行以下命令,获取原有服务配置文件。其中helm-huawei-csi为旧版本安装时指定的Helm Chart名称,huawei-csi为旧版本安装时指定的Helm Chart命名空间。

helm get values helm-huawei-csi -n huawei-csi -a > ./update-values.yaml执行vi update-values.yaml命令打开 6 中获取的文件,修改images配置项,更新镜像至最新版本。需要修改的参数请参考 表1 。

表 1 images配置项

livenessprobe sidecar镜像。

csi-resizer sidecar镜像。

csi-node-driver-registrar sidecar镜像。

registry.k8s.io/sig-storage/csi-node-driver-registrar:v2.9.0

csi-snapshotter sidecar镜像。

snapshot-controller sidecar镜像。

csi-provisioner sidecar镜像。

csi-attacher sidecar镜像。

(可选)在升级过程中如需自定义更新配置项信息或者需要新增配置信息,可参考 Helm values.yaml参数说明 修改update-values.yaml文件中配置信息。

升级时,如果update-values.yaml与values.yaml配置文件中存在相同配置项,update-values.yaml中的配置将会优先生效。执行以下命令,升级华为CSI。其中helm-huawei-csi为指定的Helm Chart名称,huawei-csi为指定的Helm Chart命名空间,update-values.yaml为步骤 6 中获取的文件。

helm upgrade helm-huawei-csi ./ -n huawei-csi -f ./values.yaml -f ./update-values.yaml完成huawei-csi服务部署后,执行命令检查服务是否启动。

kubectl get pod -n huawei-csi命令结果示例如下,Pod状态为“Running“表明服务启动成功。

NAME READY STATUS RESTARTS AGE huawei-csi-controller-6dfcc4b79f-9vjtq 9/9 Running 0 24m huawei-csi-controller-6dfcc4b79f-csphc 9/9 Running 0 24m huawei-csi-node-g6f4k 3/3 Running 0 20m huawei-csi-node-tqs87 3/3 Running 0 20m

5.1.4.1.3 - CCE或CCE Agile升级华为CSI

前提条件

已下载新版本CSI的软件包。

操作步骤

- 参考 CCE或CCE Agile卸载华为CSI 卸载CSI。

- 参考 CCE或CCE Agile平台安装华为CSI 安装新版本的CSI。

5.1.4.2 - 手动升级

本章节介绍如何手动升级华为CSI。

升级/回退过程中,已经存在的PVC/快照/Pod等资源会正常运行,不会影响您的业务访问。

- 部分2.x版本CSI已经下架,若升级失败,可能无法回退到已下架版本的CSI。

- 在升级/回退过程中,不能使用华为CSI创建新的资源,或者对已有的PVC做挂载/卸载操作。

- 在升级/回退过程中,请勿卸载Snapshot依赖组件服务。

2.x和3.x版本的CSI升级至4.10.0版本

如果您从2.x和3.x版本的CSI升级至4.10.0版本,请按照以下操作步骤升级:

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

执行命令备份后端信息到configmap.json文件中。OpenShift平台使用oc替换kubectl命令。

kubectl get cm huawei-csi-configmap -n huawei-csi -o json > configmap.json参考 手动卸载 卸载CSI。

参考 手动安装 安装当前版本的CSI。

从4.x版本的CSI升级至4.10.0版本。

如果您从4.x版本的CSI升级至4.10.0版本,请按照以下操作步骤升级:

5.1.5 - 回退

5.1.5.1 - 使用Helm回退

如果您从2.x和3.x版本的CSI升级至4.10.0版本失败,需要回退时,请参考 使用Helm卸载 卸载CSI,然后下载安装升级之前版本的CSI。

- 在升级/回退过程中,已经存在的PVC/快照/Pod等资源会正常运行,不会影响您的业务访问。

- 在升级/回退过程中,不能使用华为CSI创建新的资源,或者对已有的PVC做挂载/卸载操作。

- 在升级/回退过程中,请勿卸载Snapshot依赖组件服务。

5.1.5.1.1 - Kubernetes、OpenShift、Tanzu回退华为CSI

前提条件

- 已使用Helm 3完成CSI的更新。

操作步骤

使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

进入到helm/esdk的工作目录下,目录路径请参见 表1 。

cd helm/esdkhelm history helm-huawei-csi -n huawei-csi命令结果示例如下:

REVISION UPDATED STATUS CHART APP VERSION DESCRIPTION 1 Mon Jan 8 04:15:40 2024 superseded esdk-4.4.0 4.4.0 Install complete 2 Mon Jan 8 04:16:12 2024 deployed esdk-4.10.0 4.10.0 Upgrade complete执行命令,回退CSI服务到指定版本。

其中,revision-number为 3 查询到的版本号。例如版本为:1。

helm rollback helm-huawei-csi -n huawei-csi 1命令结果示例如下,回显中有Rollback was a success,则表示回退CSI服务到指定版本成功。

Rollback was a success! Happy Helming!

5.1.5.1.2 - CCE或CCE Agile回退华为CSI

- 在升级/回退过程中,已经存在的PVC/快照/Pod等资源会正常运行,不会影响您的业务访问。

- 在升级/回退过程中,不能使用华为CSI创建新的资源,或者对已有的PVC做挂载/卸载操作。

- 在升级/回退过程中,请勿卸载Snapshot依赖组件服务。

前提条件

已下载原版本CSI的软件包。

操作步骤

- 使用远程访问工具(以PuTTY为例),通过管理IP地址,登录Kubernetes集群的任意master节点。

- 参考 操作步骤 卸载CSI。

- 参考 CCE或CCE Agile平台安装华为CSI 重新安装原版本的CSI。

5.1.5.2 - 手动回退

请参考 手动卸载 卸载CSI,然后下载安装升级之前版本的CSI。

- 在升级/回退过程中,已经存在的PVC/快照/Pod等资源会正常运行,不会影响您的业务访问。

- 在升级/回退过程中,不能使用华为CSI创建新的资源,或者对已有的PVC做挂载/卸载操作。

- 在升级/回退过程中,请勿卸载Snapshot依赖组件服务。

前提条件

已下载原版本CSI的软件包。

操作步骤

6 - 基础服务

6.1 - 存储后端管理

后端是华为存储资源的抽象概念,每台华为存储设备可以通过租户/存储池/协议等特性抽象出多个后端资源,每个后端独立存在,其中定义了为Kubernetes集群供应持久卷时所需要的华为存储信息。

本章节用于描述使用oceanctl工具配置管理存储后端。

oceanctl工具说明

- 获取oceanctl工具,将oceanctl工具拷贝到环境目录下,例如(/usr/local/bin),且赋予可执行权限,oceanctl工具位于软件包/bin/oceanctl。

- 使用oceanctl工具前请确保oceanctl工具版本与CSI版本相同。查看oceanctl版本命令参考 帮助说明 。当前版本号应为:V4.10.0。

- oceanctl工具依赖kubectl(Kubernetes平台)或oc(OpenShift平台)命令,因此需要在可执行kubectl或oc命令的节点运行。

- 默认情况下,执行oceanctl命令的用户需要有/var/log目录的读写权限。如果没有该目录权限,可通过“–log-dir=/path/to/custom”指定有权限目录作为日志文件目录。

- oceanctl创建后端的命名空间默认为huawei-csi。

- oceanctl命令详细说明请参考 oceanctl命令说明 。

6.1.1 - 配置存储后端

- 使用oceanctl创建存储后端时,输入的账号和秘钥信息保存在 Secret 对象中,建议客户容器平台根据供应商或者K8s社区的建议自行对Secret进行加密。K8s社区对Secret加密可参考 静态加密机密数据 。

- 通过json文件创建后端时,旧版本的backend名称中可能存在大写字母或"_“字符。如果出现这种情况,旧的名称将会被重映射为一个新的名称,映射过程自动发生,不会影响原有功能。例如“ABC_123”将会被映射为“abc-123-fd68e”,具体映射规则如下:

- 大写字母转换成小写字母。

- “_“字符转换成“-”字符。

- 末尾追加5位Hash码。

- 当存储后端对接租户时,在存储后端创建完成后,不允许修改租户名称。

6.1.1.1 - 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

6.1.1.1.1 - 文件系统

6.1.1.1.1.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建本地类型存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "nfs" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

创建双活类型存储后端

- 配置NAS双活前,需要在两台存储设备之间配置双活关系,包含远端设备、双活域等,仅支持文件系统双活域工作模式为双活AA模式,配置操作请参考对应存储型号的产品文档。

- 对接NAS双活后端的账号必须为存储租户的租户管理员账号。

- 除NAS双活后端外,其他后端的管理URL不能配置为在已建立双活关系的租户的逻辑管理端口的URL。

- 使用双活类型的存储后端时,请勿发放普通文件系统。否则,在逻辑端口漂移场景下,有业务中断的风险。

准备存储后端配置文件,如backend.yaml。

storage: "oceanstor-nas" name: "backend-active" namespace: "huawei-csi" urls: - "https://192.168.129.155:8088" pools: - "StoragePool001" metrovStorePairID: "2100xxxxxxxxxx0000000000600000000" metroBackend: "backend-standby" parameters: protocol: "nfs" portals: - "192.168.129.156" maxClientThreads: "30" --- storage: "oceanstor-nas" name: "backend-standby" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" metrovStorePairID: "2100xxxxxxxxxx0000000000600000000" metroBackend: "backend-active" parameters: protocol: "nfs" portals: - "192.168.129.158" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-active oceanstor-nas https://192.168.129.155:8088 2 false backend-standby oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):分别输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: user1 Please enter this backend password: Backend backend-standby is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-active oceanstor-nas https://192.168.129.155:8088 2 true backend-standby oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为"Bound" 则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-active nfs oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.155:8088 huawei-csi backend-standby nfs oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.1.2 - NFS+

本章节介绍创建NFS+协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建本地类型存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "nfs+" portals: - "10.10.30.20" - "10.10.30.30" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs+ oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

创建双活类型存储后端

- 配置NAS双活前,需要在两台存储设备之间配置双活关系,包含远端设备、双活域等,仅支持文件系统双活域工作模式为双活AA模式,配置操作请参考对应存储型号的产品文档。

- 对接NAS双活后端的账号必须为存储租户的租户管理员账号。

- 除NAS双活后端外,其他后端的管理URL不能配置为在已建立双活关系的租户的逻辑管理端口的URL。

- 使用双活类型的存储后端时,请勿发放普通文件系统。否则,在逻辑端口漂移场景下,有业务中断的风险。

操作步骤

准备存储后端配置文件,如backend.yaml。

storage: "oceanstor-nas" name: "backend-active" namespace: "huawei-csi" urls: - "https://192.168.129.155:8088" pools: - "StoragePool001" metrovStorePairID: "2100xxxxxxxxxx0000000000600000000" metroBackend: "backend-standby" parameters: protocol: "nfs+" portals: - "192.168.129.156" - "192.168.129.157" maxClientThreads: "30" --- storage: "oceanstor-nas" name: "backend-standby" namespace: "huawei-csi" urls: - "https://192.168.129.158:8088" pools: - "StoragePool001" metrovStorePairID: "2100xxxxxxxxxx0000000000600000000" metroBackend: "backend-active" parameters: protocol: "nfs+" portals: - "192.168.129.159" - "192.168.129.160" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-active oceanstor-nas https://192.168.129.155:8088 2 false backend-standby oceanstor-nas https://192.168.129.158:8088 Please enter the backend number to configure (Enter 'exit' to exit):分别输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: user1 Please enter this backend password: Backend backend-standby is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-active oceanstor-nas https://192.168.129.155:8088 2 true backend-standby oceanstor-nas https://192.168.129.158:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为"Bound" 则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-active nfs+ oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.155:8088 huawei-csi backend-standby nfs+ oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.158:8088

6.1.1.1.2 - Dtree

6.1.1.1.2.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-dtree" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" parameters: protocol: "nfs" parentname: "parent-filesystem" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs oceanstor-dtree xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.2.2 - NFS+

本章节介绍创建NFS+协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-dtree" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" parameters: protocol: "nfs+" parentname: "parent-filesystem" portals: - "10.10.30.20" - "10.10.30.30" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs+ oceanstor-dtree xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.3 - 块业务

6.1.1.1.3.1 - iSCSI

本章节介绍创建iSCSI协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "iscsi" portals: - "10.10.30.20" - "10.10.30.21" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo iscsi oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.3.2 - FC

本章节介绍创建FC协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "fc" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo fc oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.3.3 - NVMe over RoCE

本章节介绍创建NVMe over RoCE协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "roce" portals: - "10.10.30.20" - "10.10.30.21" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.1.3.4 - FC-NVMe

本章节介绍创建FC-NVMe协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "fc-nvme" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo fc-nvme oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.2 - 闪存存储(OceanStor A600/A800)

6.1.1.2.1 - 本地文件系统

6.1.1.2.1.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-a-series-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "nfs" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-a-series-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-a-series-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs oceanstor-a-series-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.2.1.2 - DataTurbo

本章节介绍创建DataTurbo协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

|

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-a-series-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "dtfs" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-a-series-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-a-series-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo dtfs oceanstor-a-series-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.3 - DME(对接OceanStor A800集群)

6.1.1.3.1 - 全局文件系统

6.1.1.3.1.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-a-series-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:26335" storageDeviceSN: 21000000000000000000 pools: - "StoragePool001" parameters: protocol: "nfs" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-a-series-nas https://192.168.129.157:26335 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-a-series-nas https://192.168.129.157:26335 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs oceanstor-a-series-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:26335

6.1.1.3.1.2 - DataTurbo

本章节介绍创建DataTurbo协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-a-series-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:26335" storageDeviceSN: 21000000000000000000 pools: - "StoragePool001" parameters: protocol: "dtfs" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-a-series-nas https://192.168.129.157:26335 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-a-series-nas https://192.168.129.157:26335 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo dtfs oceanstor-a-series-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:26335

6.1.1.4 - 海量存储(OceanStor Pacific系列)

6.1.1.4.1 - 文件系统

6.1.1.4.1.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "nfs" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs fusionstorage-nas Bound true https://192.168.129.157:8088

6.1.1.4.1.2 - DPC

本章节介绍创建DPC协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "dpc" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo dpc fusionstorage-nas Bound true https://192.168.129.157:8088

6.1.1.4.2 - Dtree

6.1.1.4.2.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-dtree" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" parameters: protocol: "nfs" parentname: "parent-filesystem" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs fusionstorage-dtree Bound true https://192.168.129.157:8088

6.1.1.4.2.2 - DPC

本章节介绍创建DPC协议类型的存储后端

配置项说明

表 1 backend配置项说明

|

| |||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-dtree" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" parameters: protocol: "dpc" parentname: "parent-filesystem" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-dtree https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo dpc fusionstorage-dtree Bound true https://192.168.129.157:8088

6.1.1.4.3 - 块业务

6.1.1.4.3.1 - iSCSI

本章节介绍创建iSCSI协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "iscsi" portals: - "10.10.30.20" - "10.10.30.21" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo iscsi fusionstorage-san Bound true https://192.168.129.157:8088

6.1.1.4.3.2 - SCSI

本章节介绍创建SCSI协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "fusionstorage-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "scsi" portals: - {"hostname01": "192.168.125.21","hostname02": "192.168.125.22"} maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo fusionstorage-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo fusionstorage-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo scsi fusionstorage-san Bound true https://192.168.129.157:8088

6.1.1.5 - 海量存储(OceanDisk系列)

6.1.1.5.1 - 文件系统

6.1.1.5.1.1 - NFS

本章节介绍创建NFS协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建本地类型存储后端

准备后端配置文件,如backend.yaml。

storage: "oceanstor-nas" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "nfs" portals: - "10.10.30.20" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceanstor-nas https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo nfs oceanstor-nas xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.5.2 - 块业务

6.1.1.5.2.1 - iSCSI

本章节介绍创建iSCSI协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceandisk-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "iscsi" portals: - "10.10.30.20" - "10.10.30.21" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo iscsi oceandisk-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.5.2.2 - FC

本章节介绍创建FC协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceandisk-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "fc" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo fc oceandisk-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.1.5.2.3 - NVMe over RoCE

本章节介绍创建NVMe over RoCE协议类型的存储后端

配置项说明

表 1 backend配置项说明

| ||||

如果启用存储拓扑感知,需要配置该参数。具体请参考配置存储拓扑感知。 | ||||

创建存储后端

准备后端配置文件,如backend.yaml。

storage: "oceandisk-san" name: "backend-demo" namespace: "huawei-csi" urls: - "https://192.168.129.157:8088" pools: - "StoragePool001" parameters: protocol: "roce" portals: - "10.10.30.20" - "10.10.30.21" maxClientThreads: "30"执行以下命令创建存储后端。

oceanctl create backend -f /path/to/backend.yaml -i yaml命令结果示例如下:

NUMBER CONFIGURED NAME STORAGE URLS 1 false backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):输入待创建后端序号,并输入账号密码。

Please enter the backend number to configure (Enter 'exit' to exit):1 Please enter this backend user name: admin Please enter this backend password: Backend backend-demo is configured NUMBER CONFIGURED NAME STORAGE URLS 1 true backend-demo oceandisk-san https://192.168.129.157:8088 Please enter the backend number to configure (Enter 'exit' to exit):检查存储后端创建结果。

oceanctl get backend命令结果示例如下,后端状态为Bound,则创建成功。

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-demo roce oceandisk-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088

6.1.2 - 管理存储后端

6.1.2.1 - 查询存储后端

执行以下命令获取查询后端帮助。

oceanctl get backend -h执行以下命令查询默认命名空间下单个存储后端。

oceanctl get backend <backend-name>执行以下命令查询指定命名空间下所有存储后端。

oceanctl get backend -n <namespace>执行以下命令格式化输出,当前支持json,yaml和wide。

oceanctl get backend <backend-name> -o json

6.1.2.2 - 更新存储后端

- 当前使用oceanctl更新存储后端信息时,仅支持更新存储后端密码以及登录存储后端的认证模式。

- 若在存储侧更新了后端的账号密码,CSI插件会因登录失败而重试,可能会导致账号被锁定。如果账号被锁定,请参考 存储侧更新密码后账户被锁定 章节修改。

6.1.2.2.1 - 更新存储后端密码

获取更新后端帮助信息

执行以下命令获取更新存储后端帮助。

oceanctl update backend -h命令结果示例如下:

Update a backend for Ocean Storage in Kubernetes Usage: oceanctl update backend <name> [flags] Examples: # Update backend account information in default(huawei-csi) namespace oceanctl update backend <name> --password # Update backend account information in specified namespace oceanctl update backend <name> -n namespace --password # Update backend account information with ldap authentication mode in default(huawei-csi) namespace oceanctl update backend <name> --password --authenticationMode=ldap # Update backend account information with local authentication mode in default(huawei-csi) namespace oceanctl update backend <name> --password --authenticationMode=local # Update backend account information with ldap authentication mode in specified namespace oceanctl update backend <name> -n namespace --password --authenticationMode=ldap Flags: --authenticationMode string Specify authentication mode -h, --help help for backend -n, --namespace string namespace of resources --password Update account password Global Flags: --log-dir string Specify the directory for printing log files. (default "/var/log/huawei")

更新后端密码示例

执行以下命令更新存储后端信息,其中backend-name为待更新后端名称。

oceanctl update backend backend-name --password根据提示输入用户名和新密码:

Please enter this backend user name:admin Please enter this backend password: backend/backend-name updated

6.1.2.2.2 - 更新存储后端登陆认证模式

更新后端登录认证类型为LDAP示例

执行以下命令更新存储后端信息,其中backend-name为待更新后端名称。

oceanctl update backend backend-name --password --authenticationMode=ldap根据提示输入用户名和新密码:

Please enter this backend user name:admin Please enter this backend password: backend/backend-name updated

6.1.2.2.3 - 更新存储后端信息

- PVC发放需要基于已配置的存储后端,因此当存储后端已经发放PVC时,请勿随便修改存储后端。

- 名称是存储后端的唯一标识,已发放PVC的存储后端不允许修改名称。

- 存储后端修改后,新增配置仅作用于新发放的卷。

- 存储后端修改期间,请勿执行卷管理操作。

操作步骤

6.1.2.3 - 删除存储后端

正在执行卷管理操作期间,请勿删除存储后端。

删除后端示例

执行以下命令获取存储后端。

oceanctl get backend命令结果示例如下:

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-1 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088 huawei-csi backend-2 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.158:8088执行以下命令删除指定存储后端。

oceanctl delete backend backend-1执行以下命令检查删除结果。

oceanctl get backend backend-1命令结果示例如下,如果回显为“not found”则删除成功。

Error from server (NotFound): backend "backend-1" not found

6.1.2.4 - 添加存储后端证书

前提条件

完成证书制作。以OceanStor Dorado为例,证书制作过程请参考: 点此前往 。

创建证书示例

提前准备好证书文件,如cert.crt。

执行以下命令获取存储后端。

oceanctl get backend命令结果示例如下:

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-1 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088 huawei-csi backend-2 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.158:8088执行以下命令为指定存储后端创建证书。

oceanctl create cert cert-1 -b backend-1 -f /path/to/cert.crt检查证书创建结果。

oceanctl get cert -b backend-1命令结果示例如下:

NAMESPACE NAME BOUNDBACKEND huawei-csi cert-1 backend-1

6.1.2.5 - 移除存储后端证书

操作步骤

执行以下命令获取存储后端。

oceanctl get backend命令结果示例如下:

NAMESPACE NAME PROTOCOL STORAGETYPE SN STATUS ONLINE URL huawei-csi backend-1 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.157:8088 huawei-csi backend-2 roce oceanstor-san xxxxxxxxxxxxxxxxxxxx Bound true https://192.168.129.158:8088执行以下命令获取指定存储后端的证书。

oceanctl get cert -b backend-1命令结果示例如下:

NAMESPACE NAME BOUNDBACKEND huawei-csi cert-1 backend-1执行以下命令删除指定存储后端的证书。

oceanctl delete cert -b backend-1检查删除结果。

oceanctl get cert -b backend-1命令结果示例如下,如果回显为“no cert found”则删除成功。

Error from server (NotFound): no cert found on backend backend-1 in huawei-csi namespace

6.2 - 存储类管理

存储类(StorageClass) 为管理员提供了描述存储 “类” 的方法。 不同的类型可能会映射到一组不同的能力定义。Kubernetes集群用户可基于存储类进行动态卷制备。

6.2.1 - 配置存储类

集群管理员可以根据需要定义多个存储类对象,在声明配置持久卷时,需要指定满足业务要求的存储类。华为CSI在从华为存储设备上申请资源时,会根据存储类的预置定义,创建满足业务要求的存储资源。

6.2.1.1 - 闪存存储(OceanStor Dorado/OceanStor V5/OceanStor V6及以后)

6.2.1.1.1 - 文件系统

创建存储类

准备存储类配置文件,如本例中的mysc.yaml文件,存储类配置请参考下方示例文件。

执行命令,使用配置文件创建StorageClass。

kubectl apply -f mysc.yaml执行命令,查看已创建的StorageClass信息。

kubectl get sc mysc命令结果示例如下:

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE mysc csi.huawei.com Delete Immediate true 8s

NFS协议配置示例

容器使用NFS协议对接文件系统资源时,可以参考如下存储类配置示例。该示例中,NFS挂载时指定版本为4.1。

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: mysc

provisioner: csi.huawei.com

parameters:

backend: nfs-nas-181

pool: StoragePool001

volumeType: fs

allocType: thin

authClient: "*"

mountOptions:

- nfsvers=4.1 # NFS挂载时指定版本为4.1

NFS+协议配置示例

容器使用NFS+协议对接文件系统资源时,可以参考如下存储类配置示例。

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: mysc

provisioner: csi.huawei.com

parameters:

backend: nfs-nas-181

pool: StoragePool001

volumeType: fs

allocType: thin

authClient: "*"

双活文件系统配置示例

容器使用NFS双活文件系统作为存储资源时,可以参考如下配置示例。该示例中,使用的后端是支持双活的后端,且配置“hyperMetro”参数为“true”。

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: mysc

provisioner: csi.huawei.com

parameters:

backend: nfs-hypermetro-dorado-181

pool: pool001

volumeType: fs

hyperMetro: "true" # 发放双活卷

allocType: thin

authClient: "*"

- 发放NAS双活卷前,需要在两台存储设备之间配置双活关系,包含远端设备、双活域等,仅支持文件系统双活域工作模式为双活AA模式,配置操作请参考对应存储型号的产品文档。

- 若存储发生故障,逻辑管理端口可能产生漂移,在漂移状态下删除NAS双活卷后,需手动清理对应的存储资源。

文件系统支持的存储类参数详细说明

表 1 StorageClass配置参数说明

以Kubernetes v1.22.1为例,支持数字、小写字母、中划线(-)和点(.)的组合,并且必须以字母数字开头和结尾。 | |||||

|

| ||||

常见的mountOptions参数参考表2。 | |||||

如果不设置,华为CSI会在所选后端上随机选择一个满足容量要求的存储池创建资源。建议指定存储池,确保创建的资源在预期的存储池上。 | |||||

|

PVC命名空间为:"namespace",PVC名称为:"pvc-1",PVC UID:"c2fd3f46-bf17-4a7d-b88e-2e3232bae434"。 volumeName配置为: "prefix-{{ .PVCNamespace }}_{{ .PVCName }}"。 最终存储资源名称为:"prefix-namespace_pvc-1-c2fd3f46bf174a7db88e2e3232bae434"。 | ||||

| |||||

| |||||

可以使用“*”表示任意客户端。当您不确定访问客户端IP信息时,建议使用“*”防止客户端访问被存储拒绝。 可以同时输入多个主机名称、IP地址或IP地址段,以英文分号隔开。如示例:"192.168.0.10;192.168.0.0/24;myserver1.test" | |||||

在DeviceManager管理界面,选择“服务 > 文件服务 > 文件系统 > 创建 > 应用类型”,获取应用类型名称。 | |||||

配置项值是字典格式的JSON字符串(字符串两边由单引号修饰,字典key由双引号修饰)。如:'{"maxMBPS": 999, "maxIOPS": 999}' | 支持的QoS配置请参考表3说明。 | ||||

| 当使用的后端是双活类型的后端,且需要发放双活卷时,设置该参数为"true",若设置为"false",在后端对接的逻辑管理端口漂移的场景下,有业务中断的风险。 | ||||

|

| ||||

| |||||

| |||||

| |||||

| |||||

| |||||

| |||||

是否禁用卷容量校验,禁用后将不校验卷容量是否为扇区大小整数倍。

| |||||

配置项值是字典格式的JSON字符串(字符串两边由单引号修饰,字典key由双引号修饰)。如:'{"CAPACITYTHRESHOLD": 90}' | 支持的高级参数列表请参考表4说明。 |

表 2 常用mountOptions参数说明

表 3 支持的QoS配置

可选参数(未明确指定将使用后端存储默认值,具体参考相关存储资料)。

| |||

| |||

表 4 支持的高级创卷参数

6.2.1.1.2 - Dtree

创建存储类

准备存储类配置文件,如本例中的mysc.yaml文件,存储类配置请参考下方示例文件。

执行命令,使用配置文件创建StorageClass。

kubectl apply -f mysc.yaml执行命令,查看已创建的StorageClass信息。

kubectl get sc mysc命令结果示例如下:

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE mysc csi.huawei.com Delete Immediate true 8s

NFS协议支持的存储类配置示例

容器使用NFS协议对接Dtree资源时,可以参考如下存储类配置示例。该示例中,NFS挂载时指定版本为4.1。

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: mysc

provisioner: csi.huawei.com

parameters:

backend: nfs-dtree-181

parentname: parent-filesystem-name

volumeType: dtree

authClient: "*"

mountOptions:

- nfsvers=4.1 # NFS挂载时指定版本为4.1

NFS+协议支持的存储类配置示例

容器使用NFS+协议对接Dtree资源时,可以参考如下存储类配置示例。

kind: StorageClass